IA Quantique : une convergence inéluctable

du Général Patrick Perrot

Annoncée comme une prochaine rupture notamment dans le domaine de l’informatique, la technologie quantique s’annonce porteuse d’espoirs dans de nombreuses disciplines. Exécuter des traitements complexes en quelques minutes, assurer une meilleure sécurité des liaisons et tendre vers l’ubiquité sont quelques unes des opportunités que pourraient offrir le domaine quantique. Pourtant, cette discipline n’est pas nouvelle mais elle était jusqu’alors peu accessible par la complexité de ses principes théoriques. Aujourd’hui, ces mêmes principes ne se sont pas simplifié mais ils sont en passe d’accéder au monde de la physique classique et d’avoir en conséquence des répercussions sans précédent dans le monde réel. L’intelligence artificielle, quant à elle, ne semble limitée que par des capacités de calcul insuffisantes. Comment dès lors, ces deux disciplines, pourraient ne pas converger dans les années à venir dans les domaines les plus vastes dont biensûr celui de la sécurité ?

La physique quantique en quelques mots

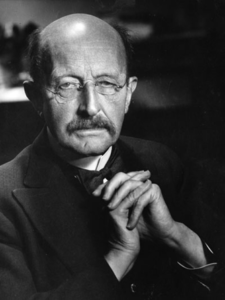

La physique quantique est née au début du 20ème siècle où des scientifiques tels Marx Planck, Albert Einstein, Ernest Rutherford, Niels Bohr, Werner Heisenberg ou encore Erwin Schrödinger révèlent un monde qui ne répond plus aux règles de la physique classique. Ils parviennent par leurs travaux à quantifier des niveaux d’énergie atomique. A l’échelle de l’infiniment petit, ils démontrent que les lois qui régissent la lumière ou le mouvement sont différentes de celles existantes dans le monde macroscopique. C’est Marx Planck qui introduit la notion de quanta, le quantuum étant la plus petite mesure indivisible, que ce soit celle de l’énergie, de la quantité de mouvement ou de la masse.

Le domaine de la physique quantique explore donc l’infiniment petit où l’observation d’un phénomène influe sur les processus en cours avec une interaction entre les ondes et les particules et, où la matière peut aller d’un point à un autre sans se déplacer via un espace intermédiaire. Cela ouvre des perspectives dans la transmission de l’information.

En dépit de toutes ces promesses, la physique quantique tarde à arriver dans le monde de l’informatique notamment au regard des phénomènes de sensibilité et d’instabilité. Ce sont là, les atouts mais aussi les difficultés à résoudre, avant d’imaginer un passage à l’échelle qui est difficile à estimer puisque certains le prédisent dans les 5 ans à venir alors que d’autres ne voient pas cette émergence avant 50 ans. La vérité est certainement intermédiaire. Les premiers impacts de l’intégration quantique dans les processeurs devraient apparaître au niveau des communications, des capteurs et de l’informatique.

Une convergence prévisible entre l'IA et la physique quantique

Aujourd’hui, et même depuis quelques années des scientifiques explorent l’intérêt de la physique quantique appliquée au domaine de l’informatique. En informatique, l’élément élémentaire est le bit qui peut se traduire par deux états 1 ou 0. Toute information numérique (parole, texte, image) fait l’objet d’un codage sous forme de bits et prend donc la forme d’une succession de 1 ou de 0. Par la physique quantique, le bit est remplacé par les qubits qui, non seulement ont deux états en même temps, 1 et 0, mais peuvent en stocker bien plus. Connue sous le nom d’état de superposition, cette capacité signifie que de très nombreuses combinaisons d’informations peuvent exister en même temps. Ce phénomène de superposition est parfaitement décrit par l’exemple du chat d’Erwin Schrödinger. Ce scientifique a imaginé un exercice de pensée qui consiste à placer un chat dans une boîte équipée d’un dispositif mortel qui se met en œuvre dès lors qu’ est détectée la désintégration d’un atome. Hors, le déclenchement du mécanisme de désintégration est aléatoire. Donc, tant que la boîte est fermée, le chat est statistiquement à la fois mort et vivant. En d’autres termes, il est possible d’estimer de manière probabiliste le pourcentage de chance qu’il soit vivant ou mort. La seule solution de savoir si l’animal est vivant est d’ouvrir la boîte entraînant la perte de l’état de superposition. C’est le principe de la décohérence quantique.

Cette faculté à gérer simultanément plusieurs états accroît la vitesse d’exécution des calculs de manière exponentielle et permet un stockage conséquent. En effet, un « ordinateur quantique » pourra stocker une quantité d’information beaucoup plus importante que dans le cas de l’informatique classique tout en consommant moins d’énergie, ce qui, en matière de développement durable n’est pas négligeable.

Mais pourquoi le monde de l’infiniment petit rencontrerait-il celui de l’informatique ? Cette rencontre est en réalité inéluctable et, par voie de conséquence, elle l’est tout autant en matière d’intelligence artificielle qui exploite l’informatique comme vecteur. Aujourd’hui, le composant essentiel des ordinateurs est le transistor ou plutôt la multiplicité des transistors communiquant entre-eux. Ces derniers ne font que de réduire de taille pour atteindre des dimensions inférieures à cinq nanomètres. Cette taille de composant se rapproche progressivement du monde de l’infiniment petit où les lois physiques changent et les transistors ne fonctionneront plus, ou tout au moins, auront un fonctionnement distinct de celui d’aujourd’hui. Dans la course à la miniaturisation des composants, l’informatique va bientôt explorer le monde des atomes qui est de l’ordre du dixième de nanomètre. Nous entrerons alors dans le mode des quanta et les principes quantiques s’appliqueront.

La célérité d’analyse comme de temps de calcul de très grandes masses de données complexes pourra être réalisée beaucoup plus aisément permettant de générer et de découvrir de nouvelles inférences. L’informatique quantique va nécessiter le développement d’une nouvelle algorithmie capable de prendre en compte les particularités de l’infiniment petit des composants quantiques. En particulier, de nombreuses fonctions mathématiques dont celles exploitées en intelligence artificielle comme la résolution de systèmes linéaires, les analyses factorielles ou discriminantes, les séparateurs à vastes marges (SVM), les méthodes de clustering ou encore les inférences bayésiennes verront leurs résolutions largement accélérées par rapport aux algorithmes classiques. Il est alors possible de constater en parallèle une période de ralentissement d’utilisation des réseaux de neurones profonds qui appréhendent des phénomènes non-linéaires moins concernés par le développement quantique.

Les différents phénomènes associés à la physique quantique sont à l’origine d’un nouvel engouement pour le développement d’une IA consciente. En effet, pour nombre de chercheurs en sciences cogntives, le mode de pensée de traitement de l’information pourrait être quantique considérant que nous faisons des choix probabilistes à partir d’une superposition d ‘hypothèses. Il n’en faut pas plus pour imaginer la « conscience machine ». Inutile de prolonger ce fantasme des amateurs de science fiction ou de théories complotistes, la conscience d’une machine ne sera, ni plus ni moins, que comme son intelligence, artificielle. La physique quantique n’apportera pas de conscience réelle à l’IA …Il n’en demeure pas moins que l’IA verra son niveau de performance et sa célérité de calcul considérablement accrue par l’intégration quantique.

Au regard de ces perspectives, les industriels se sont engagés dans l’industrie de l’informatique quantique et dès 2017, IBM a produit un ordinateur de 50 Qubits mais celui-ci s’est révélé beaucoup trop instable. Nous en sommes aujourd’hui à des ordinateurs de quelques centaines de qubits et le processeur Sycamore de chez Google annonce 53 qubits stables. La grande difficulté est en effet, l’instabilité des processeurs, c’est à dire leur difficulté à rester dans un micro état quantique durant un temps suffisamment long. Aujourd’hui, cette stabilité n’est que de quelques microsecondes avant d’atteindre la décohérence, à savoir, la perte de l’état d’intrication nécessaire au calcul. Ce phénomène apparaît lorsque deux particules subatomiques sont fortement corrélées. Cette corrélation entraîne dans l’infiniment petit une perte de l’état quantique individuel de chaque particule pour créer un état unique et unifié. Dès lors, les observations de l’une des particules influencent automatiquement l’autre, ce qui, dans le cas de l’intelligence artificielle laisse augurer de nouvelles perspectives.

En crytographie quantique, par l’exploitation du phénomène d’intrication, il devient possible à un expéditeur et un récepteur d’établir une connexion sécurisée qui intègre des paires de particules intriquées. Leur état unifié permet de générer une clef sécurisée. Si l’environnement est perturbé par un attaquant, l’expéditeur comme le récepteur sauront que la communication a été compromise par la perte de l’intrication.

Les applications en sécurité et cybersécurité sont évidentes mais les hackers ne manqueront pas non plus de profiter de nouvelles opportunités. Ils pourraient, par l’informatique quantique, contourner les systèmes de chiffrement utilisés à l’heure actuelle par un accroissement des combinaisons. Les technologies robustes au hacking quantique seront bientôt un champ de recherche pour les forces de sécurité intérieure dans la course contre la criminalité.

Dans le domaine des capteurs, la physique quantique apportera une précision inégalée à l’instar du développement de l’horloge atomique. Cette précision pourrait se décliner au sein d’applications médicales, biologiques, aéronautiques, spatiales, militaires, financières mais aussi plus communes comme le transport, la navigation ou encore l’environnement. Les perspectives dans ces différents domaines sont déjà envisagées par de nombreux industriels et laissent augurer de nouveaux enjeux de souveraineté.

Une nouvelle cartographie possible de la souveraineté internationale

La physique quantique est un enjeu de souveraineté actuel indéniable dont l’Europe doit s’emparer pour ne pas être en retard comme elle l’est dans le champ de l’intelligence artificielle. Google, IBM, Microsoft annonce déjà de belles avancées et la Chine n’est pas reste, notamment dans le domaine satellitaire. Les investissements financiers américains et chinois sont considérables. Mais la course n’est pas encore perdue, des entreprises comme Thales en France ne sont pas distancées, notamment au niveau des capteurs. Nous avons également un écosystème de start-up qui a émergé dans le domaine. Cette souveraineté nécessite d’investir financièrement dans la recherche mais aussi dans le matériel et de diversifier les choix technologiques. Cela signifie qu’il faut investir dans la mise en œuvre de systèmes à base de différents qubits tels les qubits supraconducteurs, les qubits silicium, les qubits à ions piégés ou encore les qubits photoniques car ils présentent des intérêts applicatifs et des conditions de mise en oeuvre différents.

L’intelligence artificielle a, plus encore que d’autres disciplines, révélé, l’importance de la souveraineté technologique et l’hégémonie américaine et chinoise dans le domaine. L’Europe doit aujourd’hui s’inviter, par la physique quantique, dans une nouvelle cartographie de la souveraineté en ne se limitant pas qu’à un rôle de potentiel régulateur.